일러스트=강일구

이 같은 목소리 변화는 질병이 어느 정도 진행된 후에야 나타나는 증상이다. 따라서 지금까지는 목소리를 진단에 활용하기 어려웠다. 원인을 치료하기 위해 뒤늦게 병원을 찾을 뿐이다.

정신질환자 속내 짐작

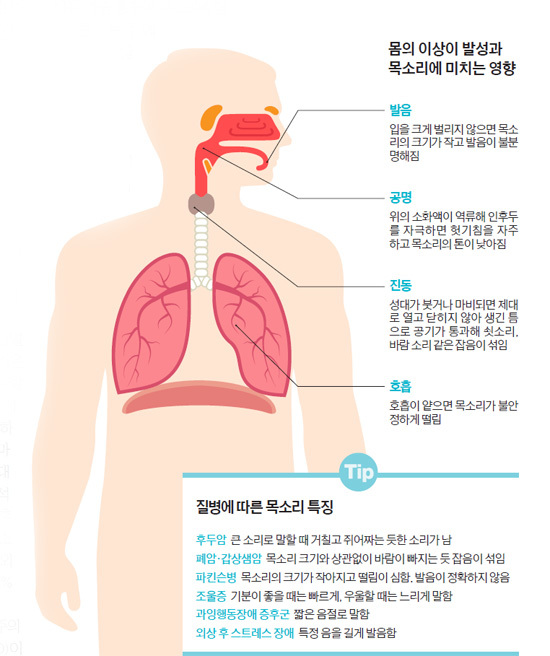

그런데 인공지능이 등장하면서 상황이 바뀌었다. 인공지능으로 질병에 따른 목소리 변화의 특징을 찾아내 다양한 질병을 조기에 감별 진단한다. 또 지속적인 모니터링으로 질병치료 효율도 높여준다. 인공지능은 목소리 패턴을 기계적으로 분석해 사람의 귀로는 감별하기 어려운 목소리 변화를 감지할 수 있다. 목소리의 행간을 읽는 것이다. 얼마나 정확하게 발음하는지, 말하는 속도는 빠르지 않은지, 말을 할 때 중간에 어느 정도 간격으로 숨을 쉬는지, 목소리가 불안정하게 떨리지는 않는지, 말끝을 흐리지는 않는지 등 비언어적인 요소를 추출해 분석한다. 예컨대 얼굴 근육을 많이 사용하는 단어의 발음 정확도가 떨어지면 외상 후 스트레스 장애(PTDS)를 의심하는 식이다.

목소리의 활용 가치가 높아지면서 의료계에서도 새로운 건강관리 도구로 주목한다. 목소리는 병·의원 방문이나 신체 손상 없이 샘플 수집이 가능하다. 서울아산병원 이비인후과 최승호 교수는 “목소리 분석이 보편화되면 보다 효율적으로 질병을 치료하고 진단하는 데 도움이 될 것으로 기대한다”고 말했다.

목소리가 지닌 힘은 생각보다 강력하다. 먼저 겉으로는 드러내지 않는 속내를 짐작할 수 있다. 조울증 같은 정신 질환이 대표적이다. 대부분 자신의 감정 표현에 솔직하지 못해 진단·치료가 쉽지 않다. 오히려 밝고 긍정적인 모습을 연출한다. 하지만 목소리에 배어 있는 감정까지 숨기지는 못한다. 미국 미시간대 정신과 맥기니스 교수 연구팀이 개발한 목소리 분석 앱 ‘프리오리(PRIORI)’가 대표적이다. 프리오리는 통화할 때 목소리의 빠르기·크기를 분석해 극단적으로 감정이 변하는 것을 미리 알려 준다. 자신은 즐겁고 쾌활한 상태라고 생각하지만 목소리 분석 결과에서는 외로움·불만족으로 나온다. 자신도 인지하지 못했던 감정을 객관적으로 바라볼 수 있다. 하던 일을 잠시 멈추는 식으로 행동 변화를 유도해 자살 위험을 낮춰준다. 만일 감정 변화가 위험한 수준이라면 자동으로 가족이나 가까운 친구·지인에게 연락해 정서적 지원을 요청한다. 목소리 분석으로 조울증 치료의 효율성을 높여준다.

외상 후 스트레스 장애도 목소리로 감별이 가능하다. 이들은 충격적인 사고를 겪은 후 정신·인지적 문제로 특정 음을 발음할 때 길게 늘어지고, 얼굴 근육을 많이 사용하는 단어를 정확하게 발음하지 못하는 특징이 있다. 뉴욕대병원 찰스 마르마 교수 연구팀이 퇴역 군인과 정상인을 대상으로 한 4만 건의 목소리 샘플을 분석한 결과다. 연구팀은 이를 토대로 외상 후 스트레스 장애를 앓고 있는 이들의 목소리 특징 30개를 찾아냈다. 이를 적용한 외상 후 스트레스 장애 진단 정확도는 77%에 이른다(Interspeech, 2015).

목소리의 리듬에 주목하기도 한다. 주의력결핍 과잉행동장애 증후군(ADHD)이다. 주의력결핍 과잉행동장애가 있는 아동은 길이가 짧은 음절로 말하는 경향이 있다는 점을 지표로 활용한다. 인공지능으로 목소리를 분석한 결과 주의력결핍 과잉행동장애 아동을 90% 정확도로 식별했다는 보고도 있다.

심장병 발생 위험 예측

치명적인 심장병 발생 위험을 예측하기도 한다. 관상동맥 혈관이 서서히 막히면서 나타나는 가슴 통증이 목소리에 영향을 준다는 점에 착안했다. 이를 입증한 연구도 있다. 이스라엘의 목소리 분석 스타트업 기업인 비욘드버벌은 미국 메이요클리닉 연구팀과 함께 목소리 변화와 심장병의 일종인 관상동맥 질환의 상관관계를 조사했다. 연구팀은 메이요클리닉을 방문한 관상동맥 질환 고위험군 150명을 두 그룹으로 나눠 한 그룹은 목소리 분석으로, 다른 그룹은 관상동맥 혈관 조영술 등 기존 방식을 관상동맥 질환 발생 위험도를 조사했다. 그 결과 목소리 분석 그룹이 기존 방식으로 이용한 것보다 진단 정확도가 19배 이상 높았다(Circulation, 2016). 현재는 관상동맥과 관련된 11개의 목소리 특징이 영어가 아닌 다른 언어(중국어)에서도 동일한지 확인하는 조사를 진행하고 있다.

로슈는 신약 임상시험에서 파킨슨병 후보 물질의 약효를 파악하기 위한 기준 중 하나로 목소리를 활용한다. 파킨슨병은 진행하면서 발음과 관련된 입술과 턱의 근육이 위축된다. 입을 크게 벌리는 범위가 줄어들어 발음의 명확도가 떨어지고, 목소리의 높낮이 변화 없이 낮고 단조로운 어조로 말한다. 목소리의 크기도 작아진다. 목소리 분석 방법은 간단하다. 임상시험에 참가한 파킨슨병 환자는 매일 최대한 길게 ‘아~’ 소리를 녹음한다. 이를 통해 파킨슨병 중증도를 수치화해 객관적으로 약의 효능을 평가한다. 기존에는 통합 파킨슨 척도 검사(UPDRS)를 통해 이를 확인했다. 하지만 이 과정에서 평가자의 주관이 개입될 수 있다.

한계도 있다. 인공지능 목소리 분석은 아직까지 연구 초기 단계다. 진단 정확성을 완벽하게 입증한 상태는 아니다. 또 식별 가능한 개인 건강정보 데이터의 보안 문제나 영어 이외의 다른 언어에도 적용 가능한지 등 해결해야 할 과제가 많다. 아주대병원 이비인후과 장전엽 교수는 “지금보다 더 구체적인 목소리 변화의 특징과 기전을 확인하는 추가적인 연구가 필요하다”고 말했다.

글=권선미 기자 kwon.sunmi@joongang.co.kr,

< 저작권자 © 중앙일보에스 무단전재 및 재배포금지 >